Giải mã sức mạnh ChatGPT - chatbot làm Google run sợ hóa ra của chính các nhà nghiên cứu tại Google

Nhiều nhà đầu tư đánh giá sự trỗi dậy ChatGPT đang mở ra một cuộc cách mạng công nghệ tương tự như việc internet hay iPhone xuất hiện trước đây. Điều này lý giải vì sao, bất chấp bối cảnh suy thoái toàn ngành công nghệ, OpenAI vẫn thu hút được vốn đầu tư với mức định giá lên đến 29 tỷ USD. Bên cạnh đó, nguồn vốn cũng đang đổ vào các startup về loại AI sản sinh (generative AI).

Trên thực tế, AI hay chatbot đều là các công nghệ đã được nói đến từ lâu nhưng chỉ đến sự xuất hiện của ChatGPT, mọi người mới nhận ra tiềm năng cũng như sức ảnh hưởng to lớn của các công nghệ này đối với thế giới. Vậy điều gì làm nên sự khác biệt cho ChatGPT so với những người tiền nhiệm mà khiến cả người khổng lồ công nghệ Google cũng phải run sợ?

Nhưng ít ai biết, trái tim cho khả năng giao tiếp như "nói chuyện với con người" của ChatGPT lại do chính các nhà nghiên cứu của Google phát triển và thực hiện mã nguồn mở cho nó: kiến trúc học sâu Transformer.

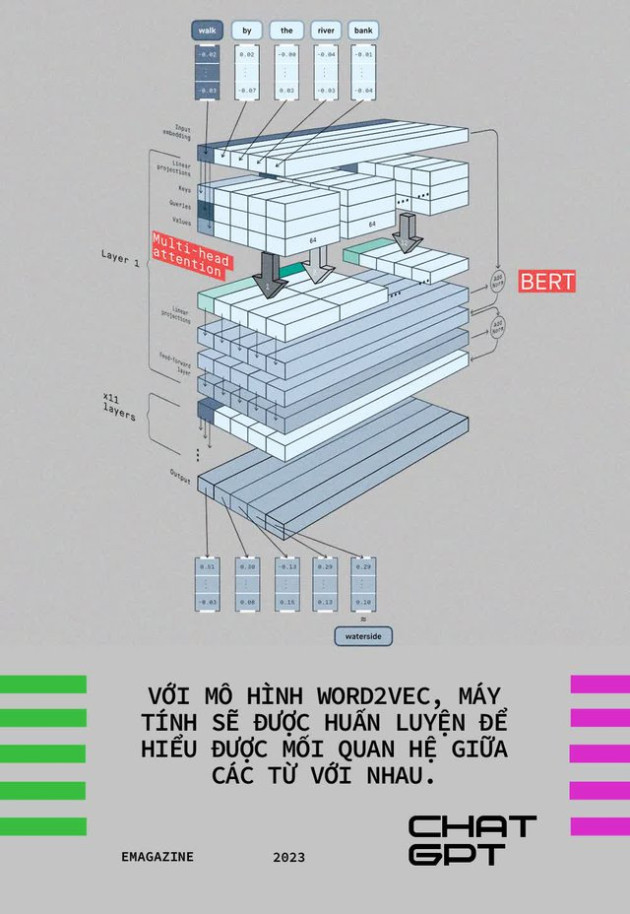

Kiến trúc này là nền tảng cho việc xây dựng nên các mô hình xử lý ngôn ngữ tự nhiên nổi tiếng như BERT của Google hay họ mô hình GPT (viết tắt của Generative Pre-trained Transformer) của OpenAI với các cái tên nổi tiếng bao gồm GPT-2 và GPT-3. Trong đó GPT-3 chính là nền tảng để tạo nên chatbot ChatGPT đang nổi tiếng hiện nay.

Không mấy nổi tiếng với công chúng nên ít ai biết rằng, sự xuất hiện của kiến trúc học sâu Transformer đã làm nên bước ngoặt cho các mô hình xử lý ngôn ngữ tự nhiên để từ đó tạo ra được một chatbot như ChatGPT. Để hiểu được tầm quan trọng này, cần biết được cách các cỗ máy xử lý ngôn ngữ con người như thế nào trước khi kiến trúc Transformer này ra đời.

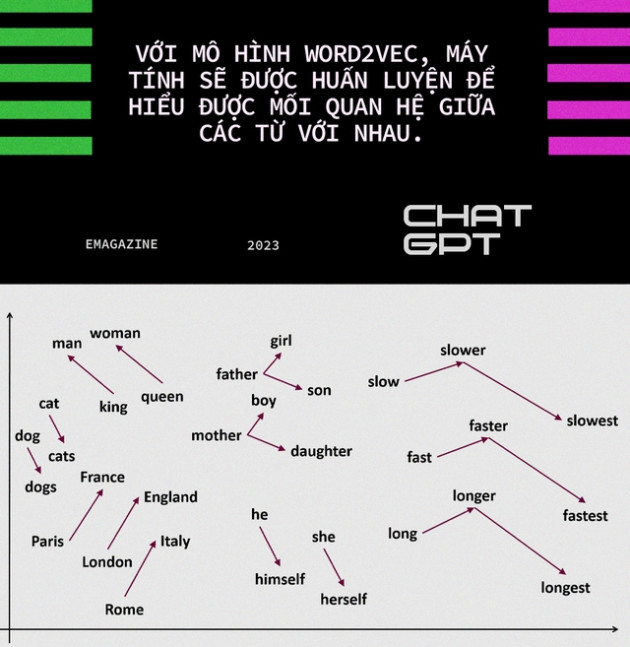

Trước đây, các mô hình ngôn ngữ tự nhiên thường đi theo hướng xử lý tuần tự các từ ngữ. Ví dụ mô hình Word2Vec cho phép huấn luyện nên các AI có khả năng hiểu được những từ liên quan đến nhau, như khi bạn nói đến điện thoại, máy tính sẽ "liên tưởng" đến cả các từ khác như "điện thoại di động", "iPhone", "Android", "màn hình cảm ứng" … Sau đó kiến trúc Mạng thần kinh nhân tạo hồi quy (RNNs) ra đời cho phép xử lý tuần tự các câu trong một đoạn văn bản.

Nhưng việc huấn luyện theo cách tiếp cận này rất chậm chạp cũng như bị giới hạn về lượng dữ liệu có thể được huấn luyện, làm cho máy tính khó có thể liên kết ý nghĩa từng từ với bối cảnh của cả đoạn văn bản hoặc cả bài viết.

Năm 2018, mô hình mới có tên ELMo (Embeddings from Language Models) được giới thiệu và là mô hình đầu tiên có khả năng xử lý ngôn ngữ không tuần tự, nhằm mô phỏng cách con người đọc và xử lý văn bản.

Dùng kiến trúc RNNs, ELMo xử lý đoạn văn bản theo 2 chiều: đọc từ đầu đến cuối và ngược lại, đọc từ cuối lên đầu để sau đó kết hợp cả 2 chiều văn bản này để hiểu được ý nghĩa của nó. Mặc dù là một bước tiến dài về khả năng xử lý ngôn ngữ nhưng ELMo vẫn gặp khó khăn khi muốn huấn luyện nó với các câu hay các đoạn văn bản ngày càng dài hơn.

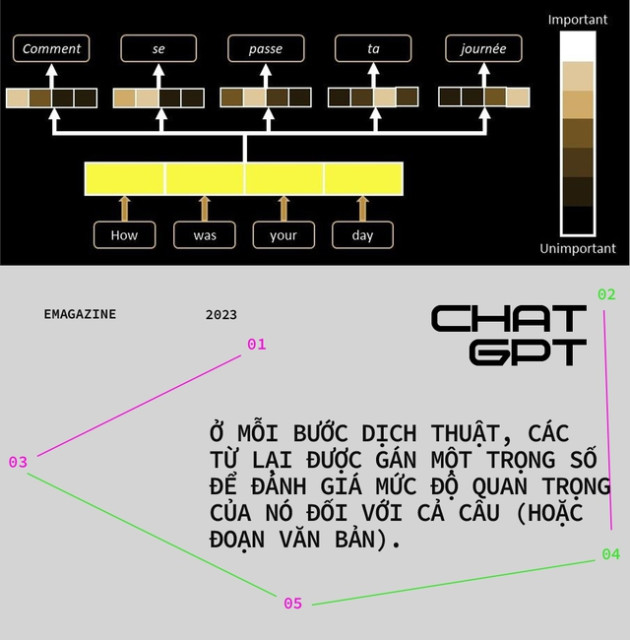

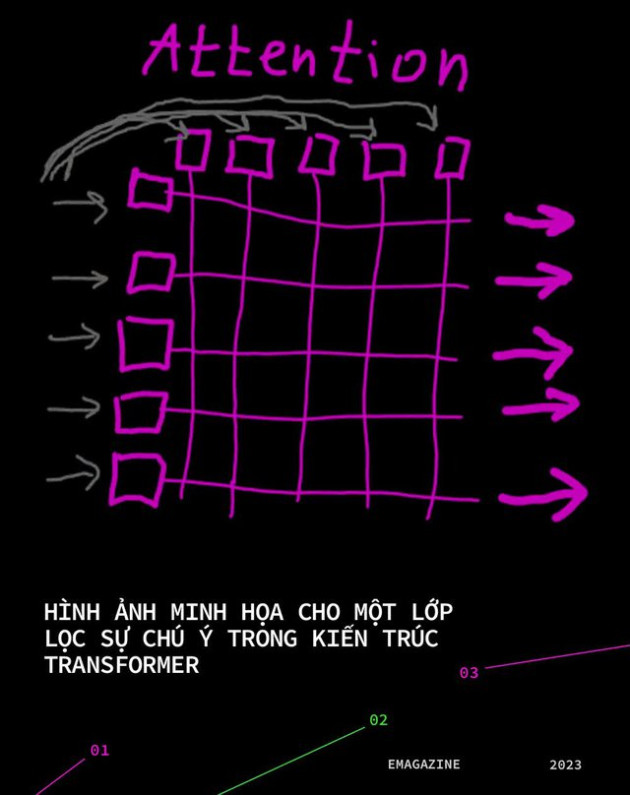

Khác với xử lý tuần tự từng từ, từng câu của các mô hình trước đó, kiến trúc Transformer của Google dựa trên cơ chế về sự chú ý (attention mechanism). Cơ chế này cho phép các mô hình xử lý ngôn ngữ dùng các lớp lọc sự chú ý (attention layer) để đánh giá được tầm quan trọng của các từ, các câu trong một đoạn văn bản dựa trên mức độ liên quan của nó đến toàn bộ văn bản đó.

Có thể nói mỗi lớp lọc sự chú ý này như một lần học hỏi thêm về đầu vào của dữ liệu, giúp xem xét các phần khác nhau của câu và khám phá thêm thông tin về ngữ nghĩa hoặc cú pháp. Các lớp lọc này cho phép mô hình vẫn duy trì được tốc độ học hỏi của mình không bị chậm đi khi độ dài của câu tăng lên. Khi đó, các mô hình xử lý chỉ việc bổ sung thêm các layer mới để lọc thêm và học hỏi thêm về dữ liệu mới. Nhờ các lớp lọc này, các mô hình có thể quét đồng thời toàn bộ văn bản và hiểu được ngữ nghĩa của nó.

Để so sánh, mô hình xử lý ngôn ngữ BERT nổi tiếng trước đây chứa 24 lớp lọc sự chú ý, GPT-2 – mô hình xử lý ngôn ngữ được OpenAI phát hành vào đầu năm 2019 – chứa 12 lớp lọc, trong khi đó GPT-3, mô hình làm nên ChatGPT hiện nay, chứa đến 96 lớp lọc sự chú ý.

Bên cạnh đó, không thể không kể đến một lợi ích khác của kiến trúc Transformer là khả năng sử dụng các mô hình được huấn luyện trước (các pre-trained models) – điều không xuất hiện cho đến khi ELMo ra mắt. Ý tưởng này tương tự như ImageNet, cơ sở dữ liệu khổng lồ các hình ảnh được gắn nhãn trước, giúp các mô hình nhận diện hình ảnh không phải huấn luyện từ đầu cho những công việc này.

Trong khi đó, các khối dữ liệu ngôn ngữ còn phức tạp, khó xử lý hơn nhiều so với các dữ liệu nhận diện hình ảnh. Do vậy, các mô hình xử lý ngôn ngữ cần nhiều dữ liệu hơn để nhận diện được mối quan hệ giữa các từ và các cụm từ. Do vậy, nếu không có các mô hình được huấn luyện trước, chỉ những người khổng lồ công nghệ mới đủ nguồn lực xử lý dữ liệu và huấn luyện các mô hình nhận diện dữ liệu đó, còn đối với các startup nhỏ, điều này là bất khả thi hoặc tiến triển rất chậm.

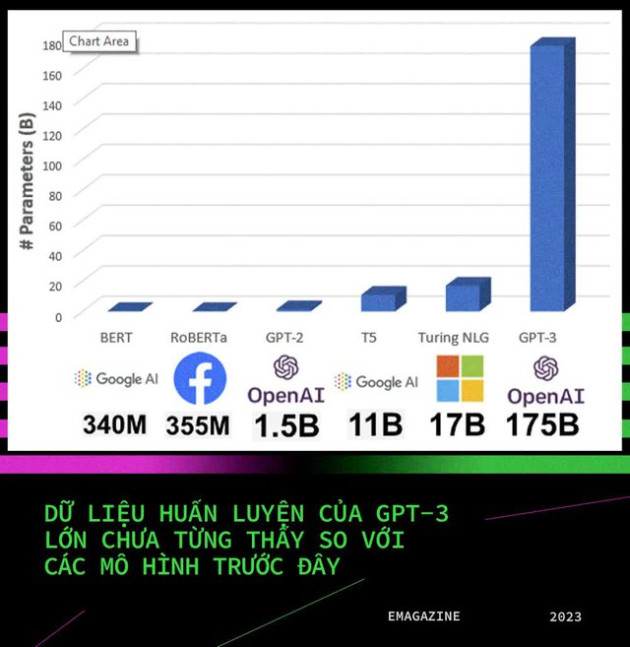

Các mô hình như GPT-3 được huấn luyện trên 45TB dữ liệu và chứa đến 175 tỷ thông số khác nhau – lớn vượt trội so với các mô hình nổi tiếng trước đây như BERT của Google, RoBERTa của Facebook, Turing NLG của Microsoft … . Khối dữ liệu của GPT-3 bao gồm hơn 8 triệu văn bản với 10 tỷ từ. Đây chính là nền tảng cho khả năng giao tiếp, trò chuyện làm nhiều người bất ngờ của ChatGPT.

Ngoài ra, một lợi ích khác của các mô hình huấn luyện trước là khả năng tinh chỉnh cho những tác vụ cụ thể mà không cần có sẵn nhiều dữ liệu. Ví dụ, đối với mô hình BERT, bạn chỉ cần vài nghìn mẫu dữ liệu là có thể tinh chỉnh mô hình cho một tác vụ mới nào đó. Còn với mô hình đã được huấn luyện với quá nhiều dữ liệu như GPT-3, chỉ cần được huấn luyện thêm với một lượng dữ liệu nhỏ cũng đủ để ChatGPT thực hiện một tác vụ mới, ví dụ như lập trình.

Trên thực tế, các yếu tố nói trên chỉ là những lợi thế về nền tảng công nghệ so với các chatbot và AI tiền nhiệm, còn để tạo nên ChatGPT với tiềm năng có thể thay đổi cả ngành công nghệ cũng như đe dọa đến vị thế của Google hiện nay, không thể không kể đến đội ngũ những nhà nghiên cứu AI bên trong OpenAI. Chính họ là người làm nên cốt lõi cho sự khác biệt mà ChatGPT đang mang lại.

Còn hơn cả một chatbot với khả năng giao tiếp như người thật, ChatGPT thực sự mở ra một cánh cửa mới cho tiềm năng trí tuệ nhân tạo và khả năng thay đổi nhiều ngành nghề kinh tế cả trong tương lai. Vì lý do đó, không khó hiểu khi thấy OpenAI đang được định giá đến 29 tỷ USD ngay cả khi chưa có mô hình kinh doanh cụ thể nào.

- Từ khóa:

- Chatgpt

- Cách mạng công nghệ

Xem thêm

- Xe VinFast VF6, VF7 chịu va chạm mạnh: Thân vỏ biến dạng ra sao, người trong xe an toàn thế nào?

- Mức giá không tưởng của iPhone 18 Pro Max

- Google đang áp dụng một thay đổi lớn chưa từng có với Gmail, có thể thay đổi cách mọi người sử dụng email mãi mãi

- Dứt tình TQ, 1 gã khổng lồ muốn bê hết công xưởng sang Việt Nam - Báo quốc tế ca ngợi: "Đây là thắng lợi lớn"

- Lần đầu tiên trong lịch sử, Google sẽ sản xuất điện thoại Pixel tại Việt Nam toàn bộ từ con số 0

- Google lần đầu tiên chọn Việt Nam làm trung tâm sản xuất điện thoại cao cấp từ con số 0

- Cựu Bộ trưởng giáo dục Indonesia bị truy tố vì gây thất thoát 125 triệu USD, Google cũng bị vạ lây vì bê bối chấn động ĐNÁ

Tin mới